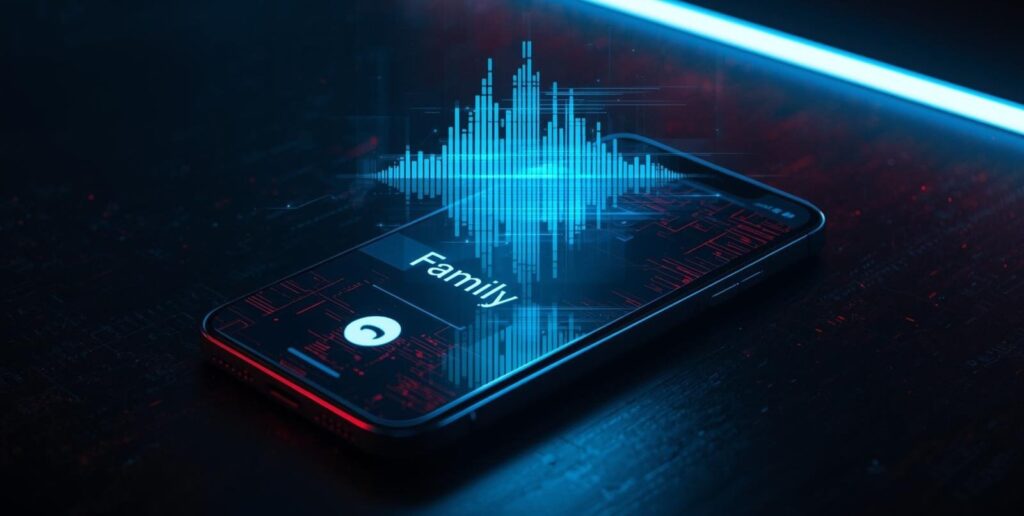

KEJAHATAN siber naik level. Bukan lagi sekadar SMS jebakan atau telepon pura-pura dari bank. Kini, scammer memanfaatkan kecerdasan buatan untuk mencuri suara kamu, lalu menggunakannya untuk menipu keluarga atau teman terdekat.

Modus ini dikenal sebagai AI Voice Spoofing, atau dalam dunia keamanan siber disebut Vishing (Voice Phishing). Cara kerjanya sederhana, tapi mematikan. Pelaku hanya membutuhkan 3–10 detik rekaman suara untuk membuat kloning digital yang terdengar sangat mirip aslinya.

Setelah itu mereka menghubungi orang terdekat korban, berpura-pura sebagai korban dan meminta uang, data pribadi, atau bantuan darurat. Banyak korban tak sadar karena percaya pada suara familiar yang terdengar asli.

Lebih Canggih, Lebih Berbahaya

Menurut riset Google Cloud, penipu semakin tertarik menggunakan teknologi AI generatif untuk membuat konten manipulatif, termasuk suara, gambar, hingga video deepfake. Mereka juga memanfaatkan model bahasa besar (LLMs) untuk mengembangkan teknik serangan lebih personal dan meyakinkan.

Baca juga: AI Bisa Tiru Suaramu, Jangan Asal Angkat Telepon!

Google melalui tim keamanan Mandiant Red Team pernah melakukan simulasi serangan deepfake suara untuk menguji ketahanan sebuah organisasi. Hasilnya, terdapat beberapa tanda yang bisa dicurigai:

- jeda canggung sebelum menjawab,

- suara terlalu stabil tanpa perubahan emosi,

- respons kaku dan tidak alami,

- adanya distorsi suara halus,

- tidak mampu menjawab pertanyaan spesifik.

Dan ya, AI bisa menipu dengan sangat halus.

Kasus Besar, Rp430 Miliar Raib Karena Suara Palsu

Salah satu kasus terbesar terjadi di Hong Kong. Sebuah perusahaan multinasional ditipu menggunakan kloning suara dan video deepfake. Total uang yang berhasil digondol pelaku mencapai HK$200 juta atau sekitar Rp430 miliar.

Baca juga: Brad Pitt Palsu Gunakan AI, Perempuan Prancis Rugi Rp 14 Miliar

Peringatan dari Para Ahli

Beberapa penyedia teknologi suara digital mengakui bahwa fitur tersebut dapat disalahgunakan. “Kami menyadari potensi penyalahgunaan alat yang sangat kuat ini dan telah menerapkan pengamanan kuat untuk melindungi dari peniruan suara,” kata Juru Bicara Resemble AI, melansir NBC News.

Senada, Sarah Myers West, co-executive director AI Now Institute, menyebut bahwa teknologi kloning suara punya risiko besar.

Baca juga: Baca juga: AI Jadi Senjata Baru Penipuan Siber, Begini Modus yang Harus Diwaspadai

“Teknologi ini jelas dapat digunakan untuk penipuan dan disinformasi, misalnya dengan menyamar sebagai tokoh institusi.”

Bagaimana Melindungi Diri?

- Jangan menerima panggilan tidak dikenal saat kondisi sensitif.

- Gunakan pertanyaan keamanan keluarga yang tidak bisa ditebak AI.

- Waspada jika suara terdengar datar dan lambat merespons.

- Jangan bagikan voice notes pribadi sembarangan di medsos.

Ke depan, dunia digital membutuhkan regulasi dan literasi yang lebih kuat untuk menghadapi kejahatan AI. Karena di era baru ini, bukan lagi data yang dicuri, tapi identitas kamu sendiri.

Dapatkan informasi menarik lainnya dengan bergabung di WhatsApp Channel Mulamula.id dengan klik tautan ini.